La gestione delle verifiche sismiche in Italia è diventata sempre più importante con il passare degli anni. Ciò è dipeso sia dalla evoluzione delle normative, sia dal fatto che numerosi terremoti avvenuti in Italia hanno messo in luce i danni spesso irreparabili che questi provocano al Paese.

Parallelamente a questa accresciuta consapevolezza, è emersa in modo sempre maggiore la convinzione che gli approcci usati dalla normativa (detti PSHA, Probabilistic Seismic Hazard Assessment) siano inattendibili e implichino verifiche di tipo "probabilistico" sostanzialmente prive di base. Tutto il sistema usato per 40 anni per verificare le strutture contro i terremoti è entrato in crisi, e nel momento in cui si scrive (Novembre 2018), si ha la sensazione di essere in una fase di cambiamento.

L'argomento è vasto e complesso, in questa sezione si vuole fornire agli utenti del programma una guida sintetica che possa aiutare a orientarsi.

Questa sezione illustra aspetti metodologici e teorici. Le due sezioni seguenti, invece, illustrano gli aspetti operativi:

Come gestire gli spettri di inviluppo dei segnali

Come fare analisi dinamiche non lineari

1. PSHA vs NDSHA

In sostanza la differenza tra i due approcci è la seguente: PSHA valuta terremoti che abbiano una certa probabilità di avvenire in un certo luogo e durante un certo lasso di tempo ed utilizza relazioni empiriche di attenuazione per modificare i segnali dalla sorgente al sito, NDSHA valuta i possibili eventi nelle faglie limitrofe al sito in esame, stimandone la magnitudo per eccesso e poi calcolando, con modelli meccanici robusti, i segnali sino alla superficie, senza l'uso di relazioni di attenuazione ma per mezzo di modellazione meccanica diretta degli strati attraversati dal treno d’onde nella sua propagazione dalla sorgente al sito.

Il metodo probabilistico valuta (presumendo di poterlo fare) la severità che un certo terremoto può avere stabilita la sua "probabilità" di occorrenza ed un certo "periodo di riferimento". Dalle due si deriva, utilizzando praticamente le stesse regole valide per il lancio dei dadi (la distribuzione Poissoniana e la binomiale quasi coincidono nel campo di interesse), il "periodo di ritorno". Dal "periodo di ritorno", usando i cataloghi ed altre fonti tra le quali il "giudizio di esperti" e l' "albero logico", si arriva a determinare una certa PGA (peak ground acceleration) che è impiegata come il principale indicatore della severità del terremoto.

Il metodo neodeterministico parte da una valutazione inviluppante della magnitudo del terremoto che può avvenire in una certa faglia. Recentemente nell'articolo seguente:

Seismogenic nodes as a viable alternative to seismogenic zones and observed seismicity for the definition of seismic hazard at regional scale,

di Paolo Rugarli, Franco Vaccari e Giuliano Panza,

appena presentato alla rivista Engineering Geology, è stato mostrato in modo rigoroso che incrementare la magnitudo alla faglia di un certo quid, valutato come γEM Δσ, nell'ordine di 0.4-0.5 (Δσ è l'errore tipico commesso nella valutazione delle magnitudo, nell'ordine di 0.2-0.25, γEM è un fattore di sicurezza nell'ordine di 2.0-2.8), è del tutto equivalente a fattorizzare il momento meccanico scambiato alla faglia con un fattore γf, compreso tra 3 e 6. Una tale osservazione, molto importante da un punto di vista teorico, riconnette quanto fatto da anni nella pratica NDSHA ai metodi per fattori parziali applicati alle azioni, già in uso ad esempio negli Eurocodici. Solo che anzichè usare un valore caratteristico della magnitudo stimato per mezzo di una (impossibile) statistica, il metodo NDSHA, come del resto contemplato dallo stesso Eurocodice 0, utilizza una stima di un suo limite superiore basata su evidenze sismologiche, storiche e geotettoniche.

Approfondimenti in merito al metodo NDSHA ed al suo confronto con PSHA possono essere trovati qui;

Come saperne di più sul metodo neodeterministico (in questa stessa guida)

Paolo Rugarli Validazione Strutturale EPC Libri, 2014 (il pertinente capitolo è liberamente scaricabile dal sito dell'Editore)

Giuliano F. Panza Antonella Peresan, Difendersi dal Terremoto si Può, EPC Libri, 2016

Norme Tecniche per le Costruzioni NTC 2018 - presentazione al volume EPC

2. Spettri di normativa e spettro compatibilità

Qualsiasi sia il metodo impiegato per pre-selezionare un certo numero di accelerogrammi da usare per le analisi sismiche, le normative in vigore in Italia (ed anche in molti altri Paesi del mondo) impongono il requisito della spettro-compatibilità. Per spettro-compatibilità si intende il fatto che ogni segnale impiegato (o molto spesso la media di un certo numero di segnali) deve comportare delle ordinate spettrali, almeno nel range di periodi significativo per la struttura in esame, non inferiori di un certo valore percentuale rispetto alle ordinate spettrali dello spettro elastico di normativa, calcolato con il medesimo smorzamento relativo al critico di riferimento. Precisamente, nel caso delle Norme Tecniche per le Costruzioni, un tale requisito è richiamato al par. 3.3.6.

Nel caso di accelerogrammi artificiali (ovvero generati per via numerica puramente in modo da essere spettro compatibili) l'ordinata spettrale media dei vari segnali utilizzati non deve presentare uno scarto in difetto superiore al 10%, in alcun punto compreso tra gli intervalli 0.15-2.0 o 0.15-2T, dove T è il periodo del primo modo della struttura (agli SLU).

Nel caso di accelerogrammi generati per simulazione del meccanismo di sorgente (ovvero proprio gli NDSHA) l'ordinata spettrale media non può essere in difetto per più del 20%. Ciò vale negli stessi intervalli di periodo indicati per i segnali artificiali (ovvero anche per periodi nei quali la struttura in esame non ha modi).

Nel caso degli accelerogrammi naturali (selezionati e scalati in modo opportuno) lo scarto in difetto non può essere superiore al 10% e quello in eccesso non può essere superiore al 30%. Tuttavia non vale lo stesso intervallo di periodi, ma solo, genericamente, vien detto "in alcun punto dell'intervallo di periodi propri di vibrazione di interesse per l'opera in esame".

Queste stringenti prescrizioni si prestano a svariati commenti.

In primo luogo il requisito che lo spettro medio soddisfi certi criteri non appare né fondato né sensato. Infatti, ciascun accelerogramma sarà utilizzato singolarmente, ai fini delle TH (time history) e quindi ciò che conta sarà semmai (ma neppure questo come si vedrà tra breve) il valore delle ordinate spettrali massime di ciascun segnale ed il suo contenuto in frequenza. Dire che la media di un carico è 100, se il massimo è 200 non ha molto senso. E nemmeno ha senso misurare gli effetti di un certo insieme di segnali prendendo il valore medio della risposta riferita a un certo indicatore (come talvolta si vede fare). L'unico approccio condivisibile è che la maggior parte dei segnali ipotizzati non deve comportare effetti disastrosi per la struttura in esame o verifiche inaccettabili. Ciò è peraltro coerente con il concetto di base di NDSHA. La pretesa di calcolare "probabilità" (in qualsiasi punto del processo, anche a valle delle stime iniziali di NDSHA), o di riferirsi ai valori medi come indicatori fisici di un qualcosa, in questo caso appare del tutto infondata. Queste "probabilità" sono artefatti numerici privi di alcun contenuto fisico. Il loro uso, teso a mettersi il cuore in pace per aver stimato qualcosa di improbabile introduce una falla logica sostanziale in un metodo, quello NDSHA, che ha come obiettivo la stima di un ragionevole inviluppo, senza la pretesa di valutarne quantitativamente la verosimiglianza. Un inviluppo è un inviluppo: bisogna prendere sistematicamente il massimo in tutti gli stadi del processo, o un adeguatamente alto percentile (che non c'entra con la probabilità). Che senso ha, a valle di una procedura che parte stimando un inviluppo per la magnitudo dell'evento di riferimento, prendere poi il valore medio degli effetti dei segnali inviluppanti?

In secondo luogo è evidente il trucco che penalizza i segnali NDSHA, costringendoli ad avere spettro compatibilità in un intervallo di periodi anche molto diverso da quello effettivamente ricompreso nella gamma dei periodi della struttura.

In terzo luogo, è proprio il requisito della spettrocompatibilità ad essere sbagliato per ragioni di principio. Infatti, la forma dello spettro di normativa è stata invalidata frequentemente dai segnali registrati nel corso di terremoti violenti (e.g. Ischia, Norcia), e quindi imporre che i segnali NDSHA vi si adattino significa esattamente buttare via (obbligare a buttare via) la parte più significativa ed informativa del metodo NDSHA, che, modellando direttamente gli strati attraversati dal treno d’onde nella sua propagazione dalla ipotizzata sorgente al sito, è anche in grado di filtrare in modo attendibile quanto avvenuto alla sorgente, dando luogo a più realistici segnali (e spettri di risposta di segnali) al sito di interesse. Di conseguenza, anche nei casi in cui - e ci sono - i segnali NDSHA risultino significativamente meno severi di quelli PSHA, il progettista è obbligato a mettere non meno del 20% di quanto previsto dalla normativa. Il bicchiere mezzo pieno è che questo 20% può essere molto importante in certi casi, in specie quando si tratti di verificare strutture esistenti.

In quarto e fondamentale luogo, come si vedrà nella sezione relativa al metodo EDEM (Elastic Deformation Energy Maximization), i valori delle ordinate spettrali per i vari modi (ovvero i picchi di risposta dei vari modi ad un certo segnale), non sono in relazione che indiretta con l'energia di deformazione effettivamente incassata dalla struttura (e quindi con il cimento a cui è sottoposta), la quale dipende in modo sostanziale dalle fasi e quindi dalle sfasature che le varie armoniche in cui si può decomporre ciascun accelerogramma hanno tra loro. Può infatti accadere che un segnale che abbia la PGA maggiore di un altro, e ordinata spettrale per il primo modo (e anche il secondo) maggiore di un altro, comporti, quando effettivamente sperimentato in una TH, una energia di deformazione di picco minore, di quella di un altro segnale, con PGA minore e con picco spettrale minore. Dunque se la domanda è "quale di questi accelerogrammi provoca gli effetti peggiori alla mia struttura", la risposta non è "quello che comporta ordinata spettrale massima per il modo dominante", ma, a fasi ormai date e obiettivamente presenti nei segnali, più verosimilmente "quello che implica in un certo istante la massima energia di deformazione del sistema".

Tutte queste importanti osservazioni convergono a far concludere che la spettro compatibilità è un concetto errato, in quanto esso poteva avere un valore quando la ricerca sismologica fondamentale non aveva raggiunto lo sviluppo odierno. Oggi è evidente che si va verso una situazione nella quale ogni struttura, posta in un certo luogo, sarà assoggettata a certi segnali scelti proprio in modo di massimizzare gli effetti proprio su quella struttura.

3. Scelta iniziale degli accelerogrammi

3.1 Approcci basati su similitudini di segnali naturali

In questo caso viene selezionato un certo numero di accelerogrammi naturali che abbiano certi requisiti in comune con il terremoto (o i terremoti) di scenario attesi. I terremoti di secnario attesi non fanno parte della informazione esplicitamente data dai metodi probabilistici (che mescolano vari scenari tra loro per dare le probabilità finali) e quindi si ottengono con un procedimento "al contrario" che è detto disaggregazione. Di fatto si tratta di tornare a considerare le singole faglie ed i singoli possibili terremoti, che è quanto già NDSHA fa nativamente.

I terremoti di scenario scelti devono avere certe caratteristiche di magnitudo M, di distanza epicentrale D, di profondità ipocentrale H. Devono inoltre avere una certa PGA. All'interno dei cataloghi mondiali dei terremoti avvenuti e registrati, si cercano quindi terremoti aventi caratteristiche simili, considerando quei segnali come segnali significativi per il (diverso) sito in esame. E' possibile che siano applicati metodi numerici di riscalatura per tener conto di vari possibili problemi, come il tipo di suolo, o le caratteristiche specifiche della faglia.

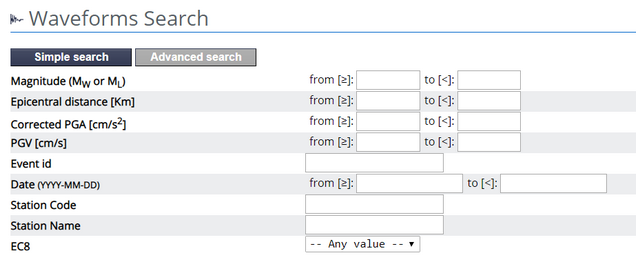

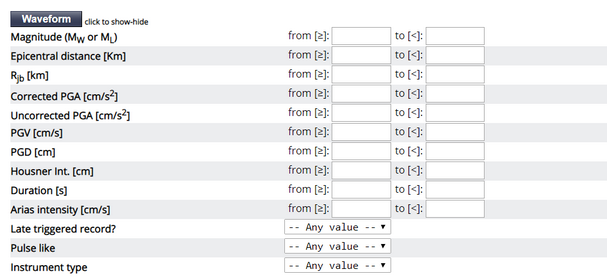

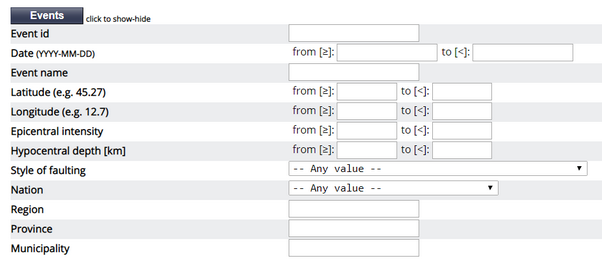

Ad esempio nel sito di INGV (ITACA: http://itaca.mi.ingv.it , waveforms), si possono specificare la PGA, la distanza epicentrale, la magnitudo e il tipo di suolo secondo EC8. Nella ricerca avanzata, si possono indicare anche altre caratteristiche.

Questo metodo di raccolta dei segnali è criticabile e non affidabile per la fondamentale ragione che omette di considerare lo specifico degli strati che il segnale dovrebbe attraversare, tra la sorgente e il sito. Quindi, anche se il segnale è stato generato da un evento avente la stessa magnitudo dell'evento ipotizzato, a una distanza epicentrale simile e a una profondità ipocentrale simile (e magari con altre caratteristiche similil), il suo contenuto in frequenza sarà significativamente diverso da quello che riguardrebbe lo specifico sito in esame. In altre parole, facendo un esempio, se trovo un terremoto avvenuto in Cile con la stessa magnitudo che sto cercando, e registrato a una distanza simile a quella che mi interessa dal suo epicentro, e riferentesi ad un evento con profondità epicentrale simile, il segnale sarà in generale anche molto diverso da quello che riguarda la faglia che sto considerando, per il sito che sto considerando, dato che la natura, struttura, morfologia e caratteristiche meccaniche degli strati profondi nella regione coinvolta in Cile, sono diversi da quelli della regione di mio interesse (in Italia, ed in un partcolare comune del territorio nazionale). Quindi, il fatto che il segnale sia naturale, ma relativo ad una diversa area del globo, non è da preferire a un segnale sintetico, che però riguarda la specifica area di mio interesse, esattamente come il suono di un campanello che cade si ode in modo differente in aria, acqua o di là da una parete.

3.2 Approcci NDSHA basati su simulazione fisica

In questo caso viene naturalmente preso in considerazione uno scenario (ovvero: senza bisogno di alcuna disaggregazione, dato che NDSHA parte proprio dai terremoti di scenario), e da esso vengono tratti un certo numero di accelerogrammi che possono riferirsi anche a diverse realizzazioni dello scorrimento di faglia. Queste realizzazioni sono associate al fatto che la faglia ha una estensione finita, dunque a seconda del punto in cui lo scorrimento inizia, e del diverso ipotizzato modo di propagarsi, si possono ottenere decine o anche centinaia di segnali diversi, tutti però aventi un marcatore comune che è la faglia che li ha generati, ed il percorso simulato che hanno fatto per giungere dalla ipotizzata sorgente al sito di interesse. Spesso è necessario, per un dato sito, prendere in considerazione più di un faglia, o più di uno scenario per una stessa faglia, e quindi si possono generare, effettivamente, centinaia di segnali per la verifica sismica di una data struttura.

Mentre anni fa una tale mole di dati sarebbe risultata intrattabile, oggi, per mezzo degli spettri di inviluppo da un lato, di EDEM o di altre possibili tecnologie, è possibile selezionare uno spettro da usare per le analisi a spettro di risposta, o, all'interno di questo vasto campione di segnali, un ristretto sottoinsieme di segnali che abbiano la capacità di massimizzare gli effetti del sisma per la particolare struttura in esame e da usare per la TH. Un tale risultato porta a un significativo cambiamento nel modo di eseguire le analisi sismiche.

Al momento in cui si scrive l'unica sorgente nota di segnali di tipo neodeterministico (NDSHA) è il sito collegato con i ricercatori della università di Trieste www.xeris.it . Non è noto il tipo di servizio offerto, i tempi ed i costi, ma si ritiene che verosimilmente questi costi possano essere compatibili con analisi relative a progetti di importanza meno che minima. Si rimanda a tale sito per avere informazioni di dettaglio.

4. Utilizzo degli accelerogrammi con il metodo dello spettro di risposta.

In linea di principio, sarebbe possibile estrarre da un vasto insieme di segnali significativi il loro spettro di inviluppo, ed usare questo al posto dello spettro di normativa. Tale approccio, in varie forme è stato proposto in questi lavori con il nome di MCSI (Maximum Credible Seismic Input):

De Natale G., Panza G. F., Petrazzuoli S., Romanelli F., Troise C., Vaccari F., Somma R., Peresan A., Seismic Hazard Assessment and Risk Mitigation at Ischia Island (Naples, Southern Italy): A Paradigm for Seismic Risk Management in Italy, International Conference on Resilience and Sustainability of Cities in Hazardous Environments 26-30 November 2018, Naples, Italy

In pratica, se dato un certo periodo T (associato a un certo modo n della struttura), si possono ottenere nacc diversi valori spettrali, ciascuno dei quali associato a uno dei nacc segnali considerati, si può prendere il massimo di tali valori e considerarlo come spettro di inviluppo. L'insieme di tutti i valori ottenuti per tutti i vari periodi T dei vari modi della struttura porta a definire una curva che è lo spettro di accelerazione di inviluppo per l'insieme dei segnali considerati. Sargon consente di calcolare questo spettro di inviluppo in modo automatico e di impiegarlo per le analisi a spettro di risposta.

Un secondo possibile modo di usare le nacc ordinate spettrali a periodo T dato, è calcolarne il valore corrispondente a un certo percentile. Tale procedura è ingannevole se pretende di associare una "probabilità" al valore trovato, mentre può essere considerata un modo per prendere un valore un po' minore del massimo, se e quando reputato eccessivamente cautelativo.

Un terzo possibile modo è quello di considerare la mediana dei nacc risultati spettrali ottenuti. In questo caso si sta considerando il 50° percentile.

Comunque, lo spettro di risposta di inviluppo vero, ovvero senza percentili, di un vasto insieme di segnali NDSHA è una curva che potrebbe effettivamente essere impiegata al posto dello spettro di normativa, per la verifica sismica mediante la analisi a spettro di risposta. E' da notare che, data che sia una certa struttura di nostro interesse per la quale sia stata fatta una analisi modale, noi non siamo interessati - come invece la norma ci impone nel caso della TH - alle ordinate spettrali in tutto un intervallo, bensì solo alle ordinate spettrali in corrispondenza ai modi di nostro interesse, ovvero solo ai periodi propri dei modi estratti della struttura. Infatti, le altre ordinate spettrali, non associate ad alcun modo di quelli della struttura, non entrano di fatto minimamente nei calcoli che vengono eseguiti dalla analisi a spettro di risposta. Dunque, in questo caso, il requisito di spettro compatibilità in grande, non ha senso. L'unico requisito che dovrà essere verificato, per essere pienamente in accordo allo spirito della norma, è quello della spettro compatibilità in piccolo, vale a dire solo in corrispondenza ai singoli modi considerati. Ma, l'uso della analisi a spettro di risposta con spettro di inviluppo su segnali sintetici, è consentito dalla normativa? Al momento in cui si scrive non sembra dato che la norma dice al par. 3.2.3.5 che

"lo spettro di risposta di progetto da utilizzare [...] è lo spettro di risposta elastico corrispondente riferito alla probabilità di superamento nel periodo di riferimento PVR considerata (par. 2.4 e 3.2.1).".

Tuttavia, se per speciali siti di particolare interesse (impianti industriali pericolosi, centrali ecc.) si ritiene di dover fornire una progettazione maggiormente sicura, allora si può anche dire che la norma non può vietare di usare spettri che comportino ordinate spettrali eguali o superiori a quelle previste dai metodi probabilistici. Ciò è quanto è sperimentalmente successo a Ischia, Norcia ed Amatrice (Fasan, M., A. Magrin, C. Amadio, F. Romanelli, F. Vaccari and G.F. Panza. 2016. A seismological and engineering perspective on the 2016 Central Italy earthquakes. International Journal of Earthquake and Impact Engineering 1: 395–420). Basta controllare la seguente figura, nel lavoro citato:

NRC: stazione a Norcia

5. Utilizzo degli accelerogrammi: time history

5.1 Time history lineare

Un modo alternativo alla analisi a spettro di risposta, per eseguire le verifiche sismiche, consiste nell'eseguire analisi di time history, vale a dire eseguire la integrazione nel dominio del tempo delle equazioni differenziali governanti e calcolare, istante per istante, come si muove la struttura, che azioni interne sperimenta, che drift di piano eccetera.

La time history lineare può essere fatta in modo molto efficiente utilizzando i risultati di una analisi modale. In questo caso si assume che il comportamento degli elementi sia lineare, e quindi non si tiene conto delle plasticizzazioni. Questa circostanza rappresenta un limite significativo, tenuto conto che la progettazione sismica odierna è - quasi sempre - basata sul concetto di dissipazione di energia e quindi sulle plasticizzazioni. Inoltre, un calcolo lineare non tiene conto degli effetti del secondo ordine.

La analisi TH lineare può comunque essere molto interessante per tutte queste ragioni:

•Dà una informazione sul livello prestazionale richiesto e sulla distribuzione elastica degli sforzi in una vera analisi nel tempo, ovvero seguendo il comportamento dinamico della struttura e considerando i modi sovrapposti senza tortuose e fisicamente prive di senso sovrapposizioni modali basate su radici quadrate.

•Consente molto rapidamente di stimare l'energia di deformazione massima richiesta da un certo segnale, anche considerando le sole zone dissipative, e quindi consente di comprendere quali segnali siano i peggiori per la struttura in esame (EDEM).

•Può essere utile per strutture che debbano rimanere in campo elastico (fattore di struttura q=1 o anche 1.5, incrementando un po' lo smorzamento modale).

•Consente agevolmente di attribuire smorzamenti modali diversi e quindi è molto utile nella analisi di sistemi isolati sismicamente, nei quali la dissipazione avviene principalmente alla base e il sistema principale resta elastico. In questo caso i modi (disaccoppiati) relativi agli smorzatori/isolatori possono essere studiati con smorzamenti relativi al critico molto superiori al classico 5% utilizzato per le parti squisitamente strutturali, e la THL è sostanzialmente esatta.

•Se l'accelerogramma è scalato del fattore di struttura, consente di verificare che i sistemi dissipativi siano progettati al loro limite elastico sotto segnali di progetto scalati del fattore di comportamento q (che è il paradigma della progettazione dissipativa).

•Consente di utilizzare il metodo EDESM (Elastic Deformation Energy Snapshot Method) per valutare la domanda non lineare (vedi sezione 6).

La idea di usare i segnali selezionati con EDEM per le analisi non lineari, è coerente con quanto viene fatto nelle analisi di pushover, dove si adottano distribuzioni di forze coerenti con i modi, e quindi derivate di fatto da una analisi elastica (si veda anche la sezione 6).

5.2 Time history non lineare

Si tratta del modo di elezione per eseguire le verifiche sismiche. Dato che la struttura è seguita in campo non lineare, si può valutare in modo effettivamente corretto (nei limiti delle approssimazioni) come i vari indicatori di cimento evolvano nel tempo (interstorey drift, elongazioni, deformazioni plastiche puntuali, ecc.). Il problema delle analisi non lineari è che comportano un onere computazionale maggiore di quelle lineari, tuttavia, il loro uso è consigliato quando coniugate con buoni sistemi di preselzione di accelerogrammi, come EDEM. In pratica con EDEM si usa una serie (anche numerosa) di TH lineari, per decidere su quali segnali eseguire la TH non lineare. Come sistema di scelta degli accelerogrammi viene dunque usata la THL.

A partire dalla versione 16.00 Sargon disponde del solutore dinamico non lineare DYNCURAN. Si veda Come fare le analisi dinamiche non lineari.

5.3 Scelta degli accelerogrammi per la time history

Soprattutto se si deve fare una THNL, ma anche se si devono eseguire più THL, la scelta degli accelerogrammi più significativi non si presenta semplice.

Sul fronte della pericolosità sismica, ovvero considerando quando può avvenire in un certo luogo senza tener conto del tipo di struttura da verificare, abbiamo visto che la disponibilità di segnali può essere ottenuta con diverse metodologie, le quali però hanno un ben diverso grado di attendibilità. Al momento si ritiene che gli unici segnali aventi una buona attendibilità siano quelli generati con simulazione del meccanismo di sorgente, senza l'utilizzo delle relazioni di attenuazione: in pratica i segnali NDSHA.

Scelti in qualsivoglia modo un certo numero di segnali rappresentativi della pericolosità sismica del sito a cui si è interessati, in passo successivo consiste nel pre-scegliere all'interno di essi un numero di segnali effettivamente rappresentativi del peggio che possa capitare alla struttura oggetto di esame. La strada giusta non è quindi quella di selezionare 7 o 10 segnali (o terne di segnali) spettrocompatibili e poi provarli tutti (come sembra suggerire la normativa), bensì è quella di considerare alcune centinaia di eventi e poi scegliere per mezzo di EDEM, tra questi, pochi eventi che massimizzino la domanda. Quali di questi eventi abbiano questa proprietà dipende dalla struttura, ovvero, strutture diverse potranno dover essere verificate con segnali diversi. E' da notare che il metodo EDEM (qui proposto in un programma commerciale per la prima volta al mondo, a quanto consta), è sufficientemente rapido da consentire l'esecuzione di un tale lavoro con computer domestici, e richiede tempi di calcolo relativamente limitati (minuti o decine minuti).

5.3.1 Cosa si sta cercando

Idealmente i segnali da considerare sono quelli che massimizzano la domanda, tenendo conto del comportamento non lineare della struttura. Per "domanda" si intende il valore di alcuni indicatori di cimento presi come riferimento per la determinazione delle prestazioni che la struttura è chiamata ad erogare. Questi indicatori sono tipicamente:

•gli spostamenti relativi di interpiano.

•le elongazioni dei diagonali tesi dissipativi (deformazioni massime).

•le deformazioni puntuali massime delle sezioni trasversali dei link, negli elementi dissipativi flessionali.

•lo spostamento globale di uno o più punti di controllo.

•i coefficienti di sfruttamento degli elementi nel corso della evoluzione nel tempo.

Non si è citata la tanto menzionata "rotazione rispetto alla corda" perché la disponibilità di modelli a fibre (gli unici al momento implementati in Sargon per l'analisi non lineare di elementi beam) consente di leggere direttamente il valore della deformazione plastica puntuale (con presso o tenso flessione biassiale) senza doverla ricostruire a partire da modelli a plasticità concentrata (ovvero i modelli che usano cerniere plastiche poste in una sezione degli elementi), i quali tra l'altro entrano in crisi quando il comportamento è compiutamente tridimensionale.

Se idealmente tali indici di cimento devono essere calcolati con THNL (e quindi esaminando, per ogni evento, la loro evoluzione nel tempo cercando il massimo, anche mettendo in conto la degradazione della resistenza dei link a causa della fatica oligociclica), in pratica è difficile farlo per centinaia di eventi a causa del tempo di calcolo. Sargon comunque consente la MULTI analisi sismica, ovvero di eseguire una dopo l'altra in cascata un serie di analisis sismiche. La strada giusta non è allora quella di considerare ab initio pochi segnali, da provare tutti, ma è quella di considerare molti segnali pre-selezionandoli con metodi opportuni.

5.3.2 Spettro compatibilità

Si è già detto che la spettro compatibilità richiesta dalle normative ha come effetto di forzare a considerare (in media) segnali con spettro non troppo dissimile da quello (alquanto fortunosamente ottenuto) proprio della normativa.

Va segnalato, tra l'altro, che nessun segnale può rispettare le ordinate dello spettro di normativa in ogni punto, ovvero per ogni periodo: infatti, le ordinate dello spettro di risposta della normativa si riferiscono, in generale, a segnali differenti. Quando, utilizzando il metodo dello spettro di risposta, si combinano gli effetti massimi dei modi utilizzando le relative ordinate spettrali, non si sta commetttendo un errore fisico soltanto perché, come spesso si dice, i massimi dei vari modi, combinati con una qualche forma di radice quadrata della somma dei quadrati, sono raggiunti in istanti diversi, ma anche e soprattutto perchè i massimi sono raggiunti in eventi diversi. Questa considerazione è fondamentale.

Quindi, la spettro compatibilità non ha senso se misurata su un singolo segnale, ma su un gruppo di segnali. In questo caso, lo scopo sarebbe quello di verificare che tra i segnali considerati non ne manchino tali da eccitare i modi strutturali considerati con una risposta massima paragonabile a quella dello spettro di normativa.

Ma, anche mitigata da questa considerazione, la spettro compatibilità non tiene conto che i vari modi oscillano in contemporanea, e che dato un certo indicatore di cimento, questo può essere massimizzato dalla somma di effetti di modi diversi, sfasati in un certo grado tra loro, e non individualmente aventi, in quel particolare segnale, il massimo previsto dallo spettro di risposta per il loro periodo. In altre parole ciò che conta è l'effetto combinato dei modi, non il loro picco individuale. La considerazione, già valida in campo lineare, diventa ancora più valida in campo non lineare, dove i modi, a stretto rigore, non esistono più.

Questa importante considerazione porta alle seguenti conclusioni in merito ai criteri per scegliere gli accelerogrammi.

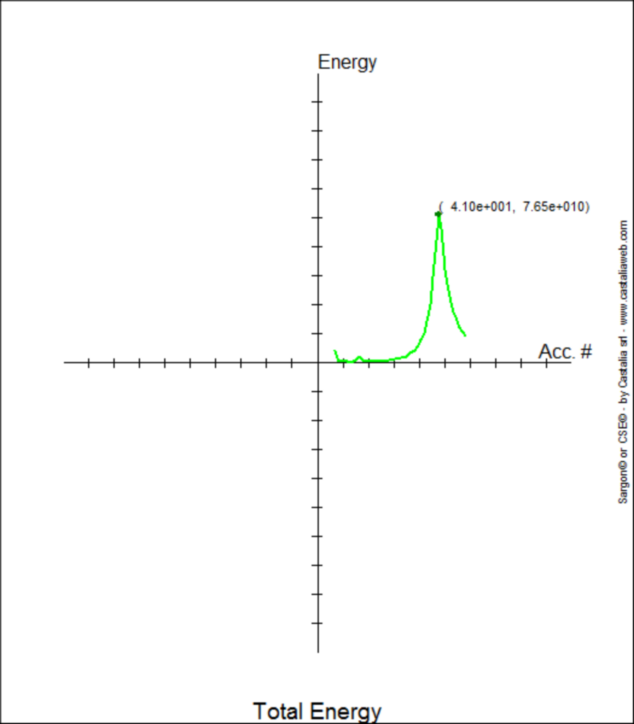

5.3.3 EDEM

Preso un certo evento ed eseguita un TH lineare basata su una precedente analisi modale, è possibile misurare, in ogni istante di tempo, l'energia di deformazione incassata all'interno della struttura. Questa energia di deformazione è in diretta correlazione con gli sforzi che sollecitano i vari elementi strutturali e quindi con il cimento cui sono sottoposti. Nel corso della storia temporale, l'energia di deformazione incassata varia, in modo che in un certo particolare istante essa raggiunge il suo massimo, normalmente misurato in Joule.

Se questa analisi è ripetuta per molti diversi eventi, è possibile creare una nuova curva che ha in ascissa il numero dell'evento sperimentato, ed in ordinata la massima energia di deformazione incassata dalla struttura per quel segnale.

Il metodo EDEM (Elastic Deformation Energy Maximization) considera gli eventi ai quali corrisponde la massima energia di deformazione come quelli più interessanti ai fini della verifica sismica. Tale principio è affine a quanto viene già implicitamente fatto da altri metodi, come il metodo dello spettro di risposta o l'analisi pushover, nel considerare la risposta elastica come un indicatore significativo non solo del comportamento lineare, ma anche del comportamento non lineare. Infatti, nella analisi a spettro di risposta la risposta elastica viene abbattuta di un fattore q, facendo quindi riferimento alla riscalatura di una risposta che in realtà è fisicamente inaccessibile, dato che la struttura si snerva prima di arrivarci. Allo stesso modo, le forze usate per l'analisi di pushover, sono quelle associate ai modi, e quindi hanno una distribuzione elastica ed intensità tali da portare invece la struttura al di fuori del campo elastico. Una stessa filosofia, applicata ad EDEM, porta direttamente al metodo EDESM (sezione 6).

A differenza degli altri metodi nominati, comunque, il metodo EDEM considera correttamente tutti i modi desiderati e la loro sovrapposizione istante per istante, e quindi considera in modo corretto le fasi.

Il metodo EDEM, con questo nome, è stato proposto per la prima volta - a quanto consta - nel seguente lavoro:

Sargon 13.00, a quanto risulta, è il primo programma che implementa EDEM come strumento di analisi sismica correntemente impiegato, e tale da inserire in un programma di analisi strutturale, considerando il comportamento dinamico complessivo della specifica struttura allo studio, la fase di scelta dei segnali ai fini della verifica sismica.

Poichè la energia di deformazione che interessa è specificamente quella incassata dagli elementi dissipativi (dato che una grande struttura può incassare molta energia di deformazione in elementi elastici senza che questo rappresenti un problema), il metodo è stato implementato dando due curve, per ogni accelerogramma considerato, e due curve finali riepilogative:

1.La curva che dà l'energia di deformazione totale.

2.La curva che dà l'energia di deformazione nei soli elementi marcati come dissipativi per mezzo del comando Struttura-Gerarchia-Aggiungi DZONA

Esempio di curva Emax(#). In ascissa il numero di evento, in ordinata la corrispondente massima energia di deformazione incassata dalla struttura. L'evento 41 è il peggiore.

Le curve date per ogni accelerogramma sono curve del tipo E=E(t), ovvero in ordinata c'è l'energia di deformazione ed in ascissa il tempo. Le due curve riepilogative sono invece curve del tipo Emax = Emax(#), dove # è un identificatore numerico di evento, ed Emax è la massima energia di deformazione in funzione del tempo, per quell'evento.

Per la precisione, quando si conteggia l'energia di deformazione dei soli elementi dissipativi, si considera solo la energia di deformazione associata alle componenti di sollecitazione associate al meccanismo dissipativo. Quindi:

•per elementi biella alla sola azione assiale.

•per i link delle strutture EBF o per gli estremi delle strutture MRF, la flessione e il taglio associati all'asse forte.

Per rendere lo studio più significativo, è possibile selezionare solo alcuni modi e scartare gli altri, ed è possibile, opzionalmente, far entrare nel conteggio i soli elementi selezionati. Al momento EDEM è implementato conteggiando solo gli elementi trave e biella.

Avuta la curva che dice quale evento massimizza l'energia di deformazione della nostra struttura, quell'evento sarà impiegato per l'analisi sismica Time History. E' da notare nuovamente che quale sia questo evento, dipende dal suo contenuto in frequenza quando rapportato alla specifica struttura in esame, con i suoi particolari modi. Assoggettando agli stessi eventi un'altra struttura, si troverà in generale che un diverso evento ne massimizza la risposta elastica.

In particolare, risulta sperimentalmente, analisi numeriche alla mano, che l'evento che massimizza la risposta in particolare nelle zone dissipative, ma anche in linea di principio nella intera struttura, non è, in generale, l'evento che comporta le massime ordinate spettrali sul modo dominante, ma è l'evento che eccita nel modo peggiore i modi spingendoli a sovrapporsi nel modo più pericoloso.

Questa osservazione, fondamentale, porta a considerare con spirito critico la metodologia basata sulla selezione accelerogammi aventi ordinate spettrali che massimizzino la risposta su uno o più modi.

E' da notare che la sfasatura tra i modi può anche apportare un effetto di riduzione del cimento, e non solo un effetto di accrescimento. Per questo motivo, il numero di segnali impiegati per le valutazioni EDEM dovrebbe essere significativo.

5.3.5 Massimizzazione delle ordinate spettrali

Il metodo consiste nel considerare lo spettro di inviluppo dei segnali potenzialmente interessanti, e nello scegliere, come accelerogrammi da impiegare nelle TH, i segnali per i quali è massima, rispetto a tutti gli altri, la risposta di un oscillatore semplice avente periodo proprio eguale a quello dei modi dominanti della struttura in esame. In generale, ad ogni modo corrisponderà un particolare segnale, che massimizza la ordinata dello spettro in corrispondenza a quel dato periodo.

Per le ragioni già spiegate non sembra che tale metodo sia a favore di sicurezza, dato che si sono trovati esempi in cui questo segnale (con ordinata spettrale massima sul modo dominante) comporta una energia di deformazione complessiva molto molto minore di quella raggiunta da altro segnale, privo di tale proprietà.

6. EDESM (Elastic Deformation Energy Snapshot Maximization)

Il metodo è una elaborazione di EDEM. Avuto l'evento che comporta la massima energia di deformazione, nell'istante tM che corrisponde a questo massimo si possono calcolare delle forze nodali equivalenti, tali da generare, nella struttura, l'energia di deformazione misurata da EDEM. In pratica si prende una istantanea (snapshot) di quanto avviene in un certo istante in campo elastico, e lo si esamina poi in campo plastico.

Queste forze nodali, in un certo istante sono

![]()

L'idea, in analogia a quanto fatto con il sistema della pushover, è quella di utilizzare queste forze per eseguire una analisi non lineare statica, e verificare, in questo modo, la diffusione della plasticità nel sistema e l'entità della domanda.

Sebbene tale metodo non sia a rigore esatto, dato che la forma della oscillazione e così le forze apparenti, cambia quando si abbandona la fase elastica, l'errore commesso non è in linea di principio diverso da quello commesso da altri metodi comunemente accettati (pushover, analisi a spettro di risposta). La quantificazione di questo errore è al momento in fase di studio ed a tale quantificazione si riferiranno prossimi lavori di ricerca su questo tema.

E' possibile chiedere di caricare le forze nodali corrispondenti all'istante in cui è massima l'energia incassata dalla struttura (o dalle parti dissipative della struttura), in un certo caso di carico che verrà svuotato. Queste forze possono poi essere utilizzate in campo lneare o non lineare.